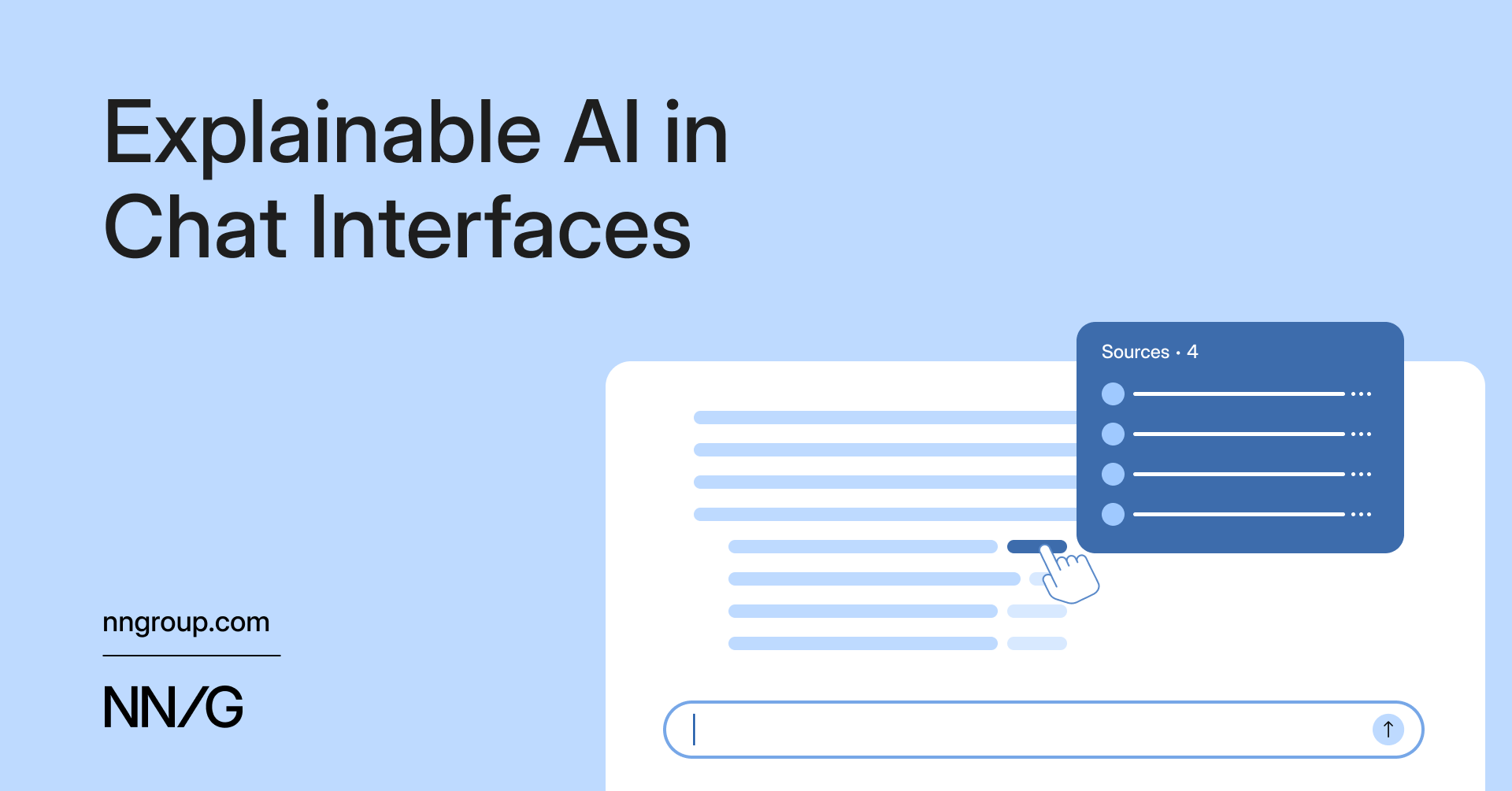

IA explicable en interfaces de chat

Resumen:

El texto explicativo en las interfaces de chat de IA tiene como objetivo ayudar a los usuarios a comprender los resultados de la IA, pero las prácticas actuales no logran este objetivo.

A medida que las interfaces de chat de IA se vuelven más populares, los usuarios dependen cada vez más de los resultados de la IA para tomar decisiones. Sin explicación alguna, un sistema de IA es una caja negra. Explicar a las personas cómo los sistemas de inteligencia artificial logran resultados específicos, ayudando a los usuarios a obtener resultados precisos. modelo mentalevite la difusión de información errónea y ayude a los usuarios a decidir si confiar en los resultados de la IA. Sin embargo, las explicaciones proporcionadas por los modelos de lenguajes grandes (LLM) actuales suelen ser inexactas, ocultas o confusas.

Este artículo se centra en cómo aparece el texto explicativo en las interfaces de chat de IA, qué funciona y qué no, y cómo los equipos de UX pueden continuar diseñando explicaciones de IA.

inteligencia artificial explicable

La IA explicable consiste en hacer que el razonamiento detrás de un sistema de IA sea transparente y fácil de entender. Se refiere a cómo un sistema de IA comunica el razonamiento detrás de su producción para que los humanos puedan comprenderla y evaluarla.

Desafíos que enfrenta la IA explicable

Ahora, La IA explicable está limitada por la complejidad técnica. La realidad técnica es que los modelos modernos de IA son tan complejos que incluso los ingenieros de IA no siempre pueden rastrear con precisión las razones detrás de sus resultados. Actualmente, no tenemos inteligencia artificial que pueda explicar de forma totalmente transparente todo En efecto. Los detalles técnicos de la construcción de modelos precisos e interpretables son un tema de discusión constante en la industria.

Sin embargo, cuando un chatbot de IA Presentar sus resultados con confianza., Los usuarios pueden depositar una confianza innecesaria en estas respuestas. Muchos chatbots de IA intentan proporcionar al menos una explicación básica (como una fuente) para sus respuestas, pero estas explicaciones suelen ser inexactas o imprecisas. alucinación. Los usuarios que no comprenden estas limitaciones ven explicaciones seguras y razonables y automáticamente confían en el resultado. Cuanto más confíen los usuarios en la IA, más probabilidades habrá de que utilicen herramientas de IA sin lugar a dudas.

Texto de descripción en la interfaz de chat AI

La interpretabilidad en la IA es un tema amplio; sin embargo, este artículo examina específicamente las explicaciones de texto proporcionadas por los chatbots de IA (incluidos Claude, ChatGPT, Copilot y Gemini) para contextualizar su producción.

Estas explicaciones incluyen citas de fuentes, tutoriales paso a paso y exenciones de responsabilidad. Cada modo está diseñado para beneficiar a los usuarios, pero también introduce riesgos.

Cita fuente

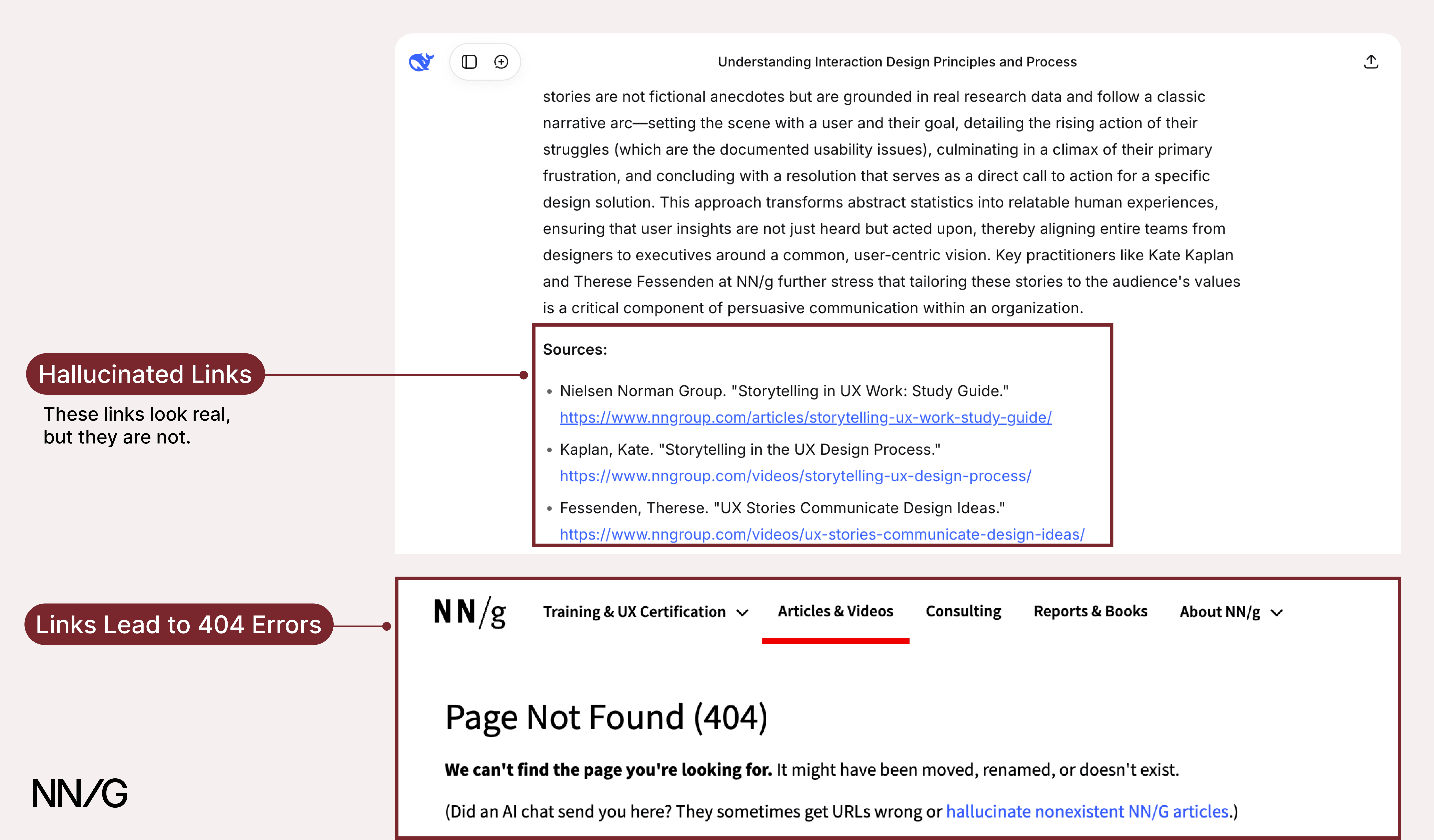

Es común que las interfaces de chat de IA citen fuentes en sus resultados. Las citas están destinadas a ayudar a los usuarios a validar el resultado. Sin embargo, para que las cotizaciones sean útiles, deben ser precisas.

La realidad es que las referencias suelen ser ilusorias y apuntan a URL que no existen. E, incluso si los enlaces son genuinos, pueden conducir a fuentes no confiables o artículos irrelevantes que en realidad no respaldan las afirmaciones hechas en el resultado de la IA. En todos estos casos, incluir la fuente (independientemente de su validez) puede dar a los usuarios una falsa sensación de confiabilidad.

Aunque en teoría los usuarios pueden verificar la información consultando cada fuente, en la práctica rara vez lo hacen. nuestra investigación Comportamiento de búsqueda de información de IA revelar La gente rara vez hace clic en enlaces de citas. Sin verificar estas fuentes, es posible que los usuarios no se den cuenta de que una cotización puede ser inexacta o incluso inventada. Debido a que la cita parece confiable, esta percepción por sí sola aumenta la confianza en los resultados. Como lo describió un participante:

“Para ser honesto, confío mucho (en el chatbot)… si quiero aprender más y ver de dónde obtiene información, simplemente hago clic en el código fuente y sigo leyendo”.

Sin embargo, este participante nunca hizo clic en ninguna de las citas presentadas durante la sesión. Es fácil para los usuarios confiar demasiado en los resultados de la IA porque Aparecer Bien citado.

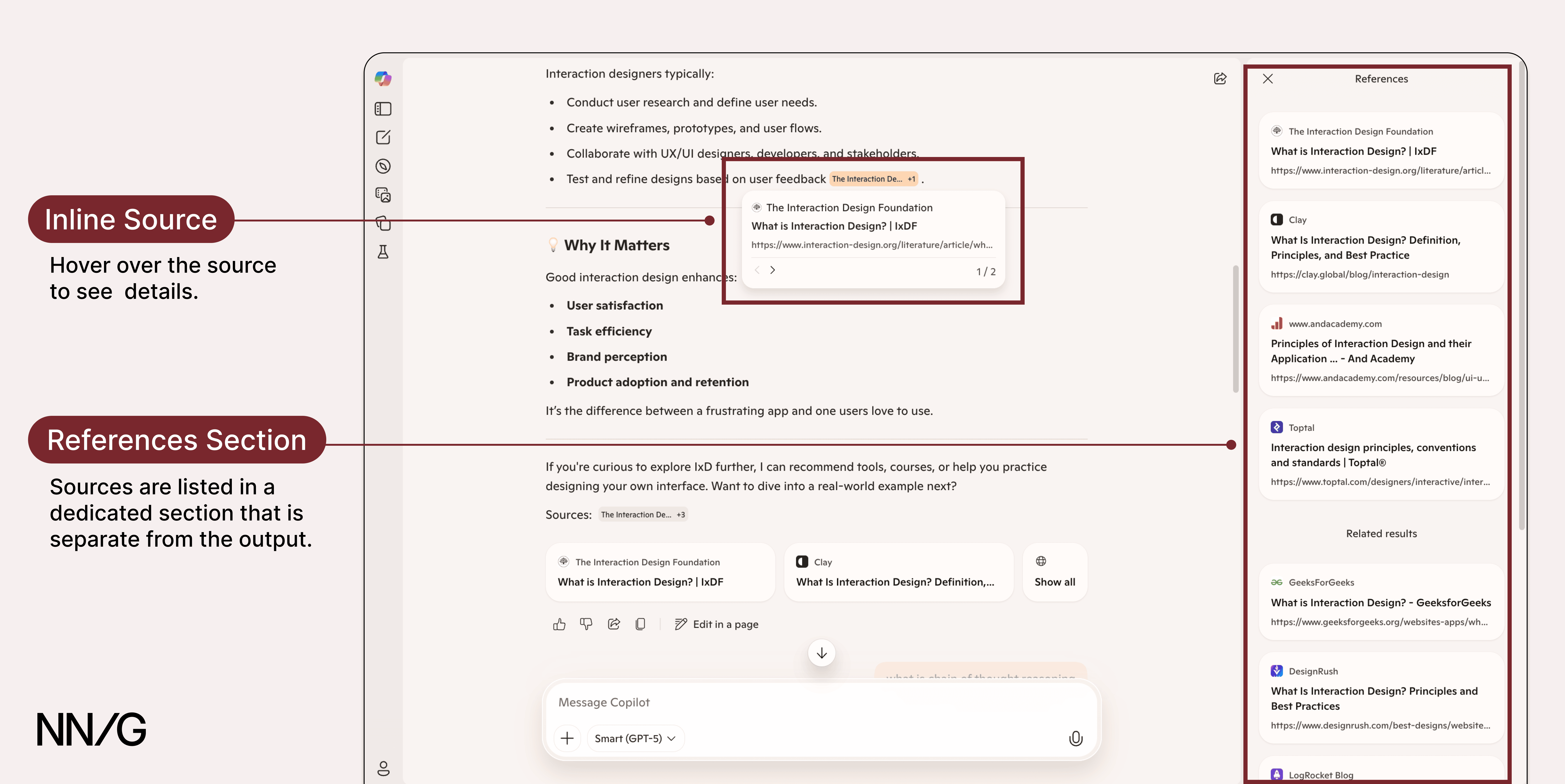

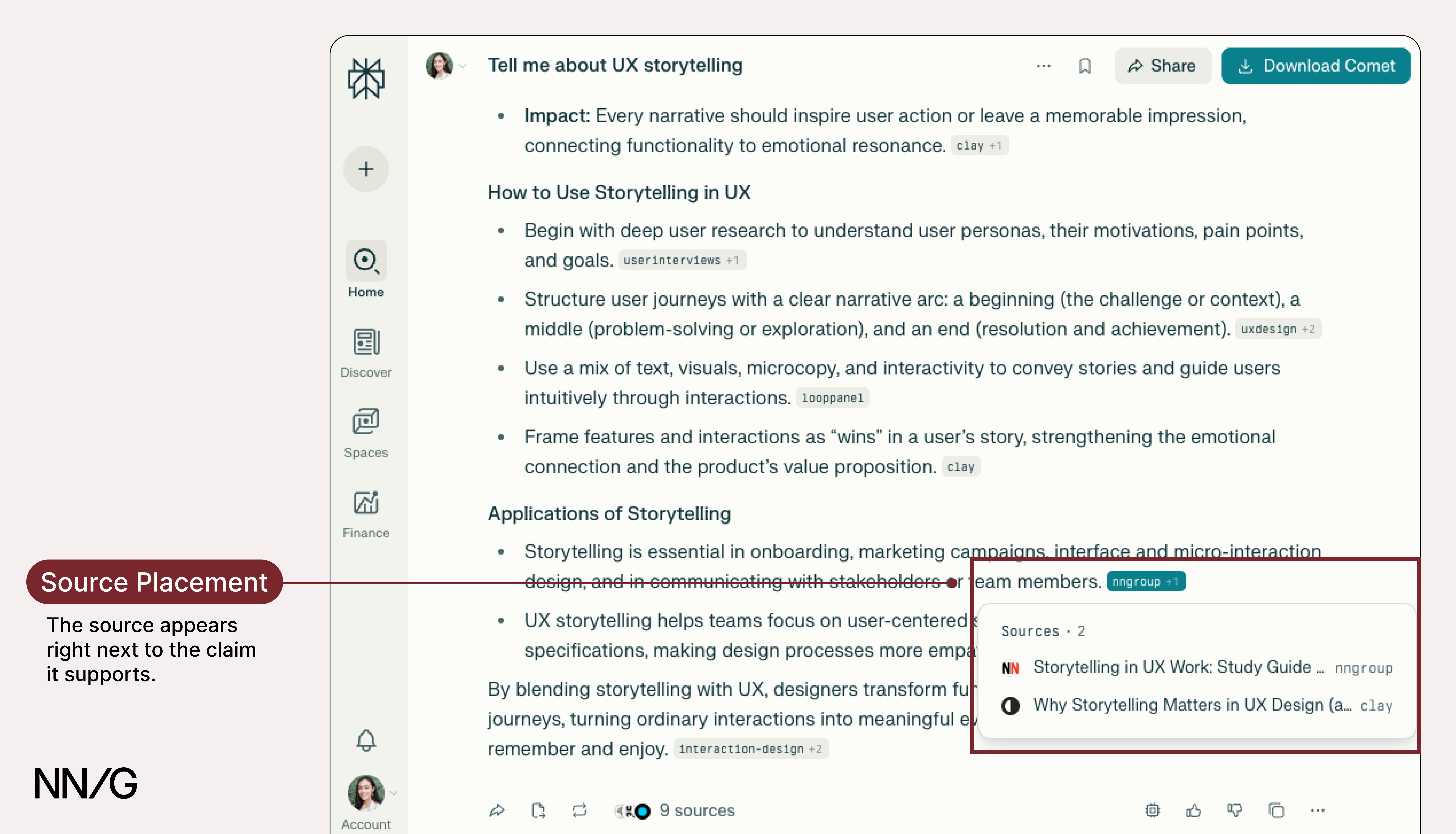

En este momento, los profesionales de UX no tienen control sobre cómo los chatbots de IA generan citas, y el contenido alucinante a menudo se integra en la forma en que funciona el modelo. Resolver este problema es un desafío técnico que está más allá del alcance del equipo de experiencia del usuario. Pero los diseñadores pueden influir en la forma en que los usuarios presentan e interpretan los recursos. Con esto en mente, aquí hay algunas formas en que los equipos de UX pueden diseñar fuentes para fomentar la validación de resultados:

- Establezca expectativas realistas. Es importante indicar claramente las fuentes de verificación en la interfaz, ya que es posible que no siempre enlacen con información precisa.

- El estilo de cita difiere de la respuesta de salida principal. No oculte citas en el cuerpo de su respuesta. Haga que las citas sean visibles y destacadas en la página para animar a los usuarios a investigar.

- Coloque las fuentes directamente al lado de las afirmaciones o frases específicas que respaldan. Esto anima a los usuarios a hacer clic en ellos y les facilita verificar la información en contexto.

- Enlace a la parte relevante de la fuente. Si es posible, enlace directamente a la parte del artículo que respalda el reclamo. Esta práctica reduce costo de interacción El proceso de búsqueda y verificación de información.

- evitar Etiquetas de enlace ambiguas, Por ejemplo fuente. Muestre etiquetas de fuentes significativas, como el nombre de la publicación o el título del artículo, para que los usuarios sepan en qué están haciendo clic.

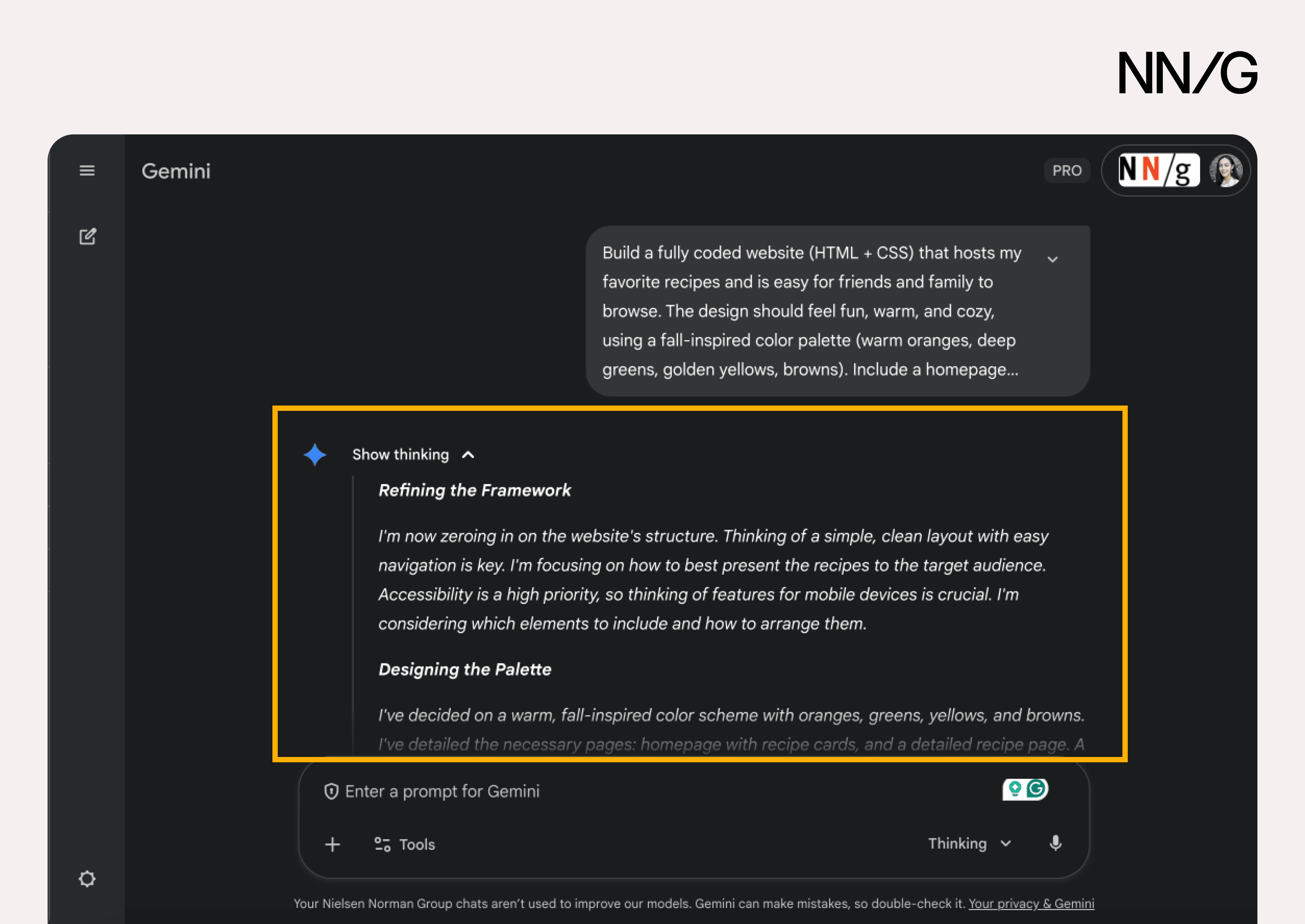

razonamiento paso a paso

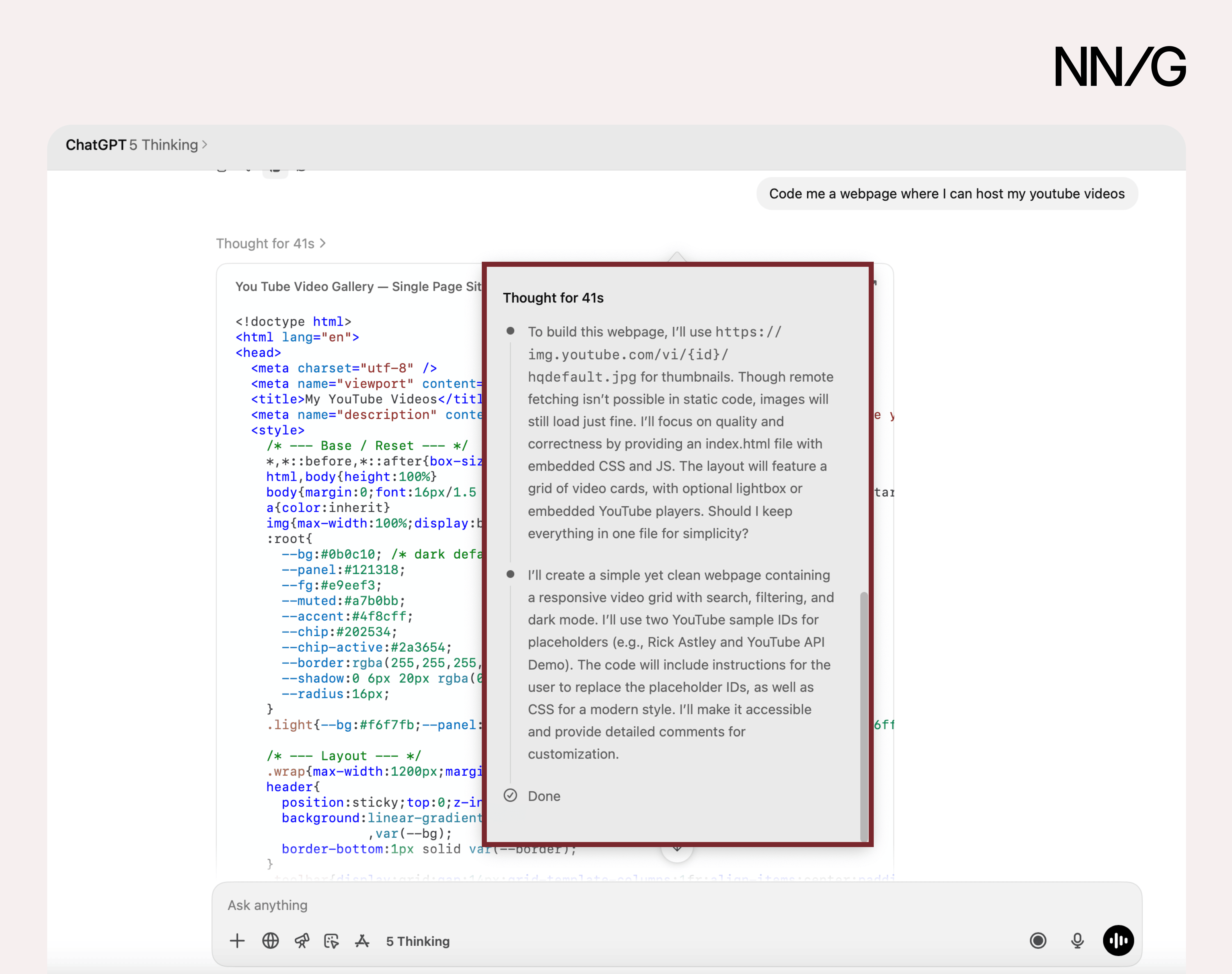

Las explicaciones paso a paso deberían ayudar a los usuarios a comprender cómo el chatbot de IA obtiene sus resultados. La idea es que si los usuarios pueden ver el proceso de razonamiento, podrán evaluar mejor la precisión del resultado.

En principio, una explicación paso a paso parece prometedora. Dan la impresión de que el sistema piensa de forma cuidadosa, lógica y transparente. Pero este no es el caso. En muchos casos, estos ejercicios son racionalizaciones generadas a posteriori en lugar de una representación fiel de cómo el modelo llegó a sus respuestas.

Las investigaciones muestran que estos Las explicaciones muchas veces son falsas a los cálculos reales del modelo. Cuando los usuarios son empujados en esa dirección, pueden ignorar los factores que influyen o ajustar sus interpretaciones para justificar respuestas incorrectas. Los resultados a menudo parecen razonables pero no son ciertos.

Esto pone a los diseñadores en un dilema. Por un lado, el razonamiento paso a paso puede hacer que un producto parezca más accesible y fácil de entender. Por otro lado, podría promover la confianza en una herramienta defectuosa.

Dado que el razonamiento paso a paso a menudo no es confiable, los diseñadores deben evitar el uso de explicaciones paso a paso que impliquen certeza o transparencia. En su lugar, utilice estrategias de explicación alternativas, como proporcionar fuentes relevantes y aclarar las limitaciones del modelo. A medida que la tecnología evolucione y mejore la verdadera interpretabilidad, los diseñadores podrán introducir explicaciones paso a paso que reflejen con precisión los procesos internos del sistema.

Descargo de responsabilidad

Se muestra un descargo de responsabilidad en la interfaz para que los usuarios sean conscientes de las limitaciones de la herramienta. Recuerdan a los usuarios que verifiquen el resultado porque la información puede ser incorrecta.

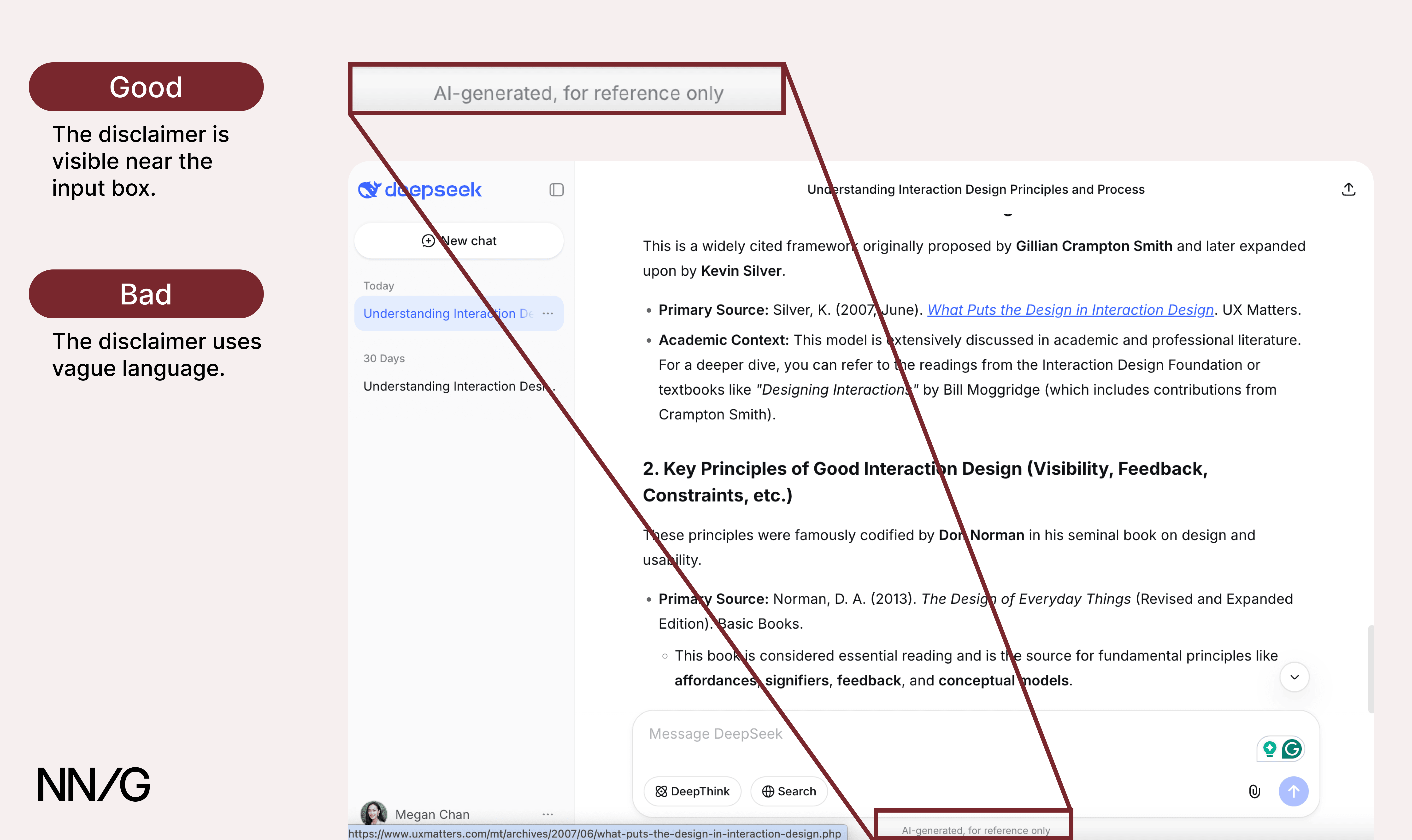

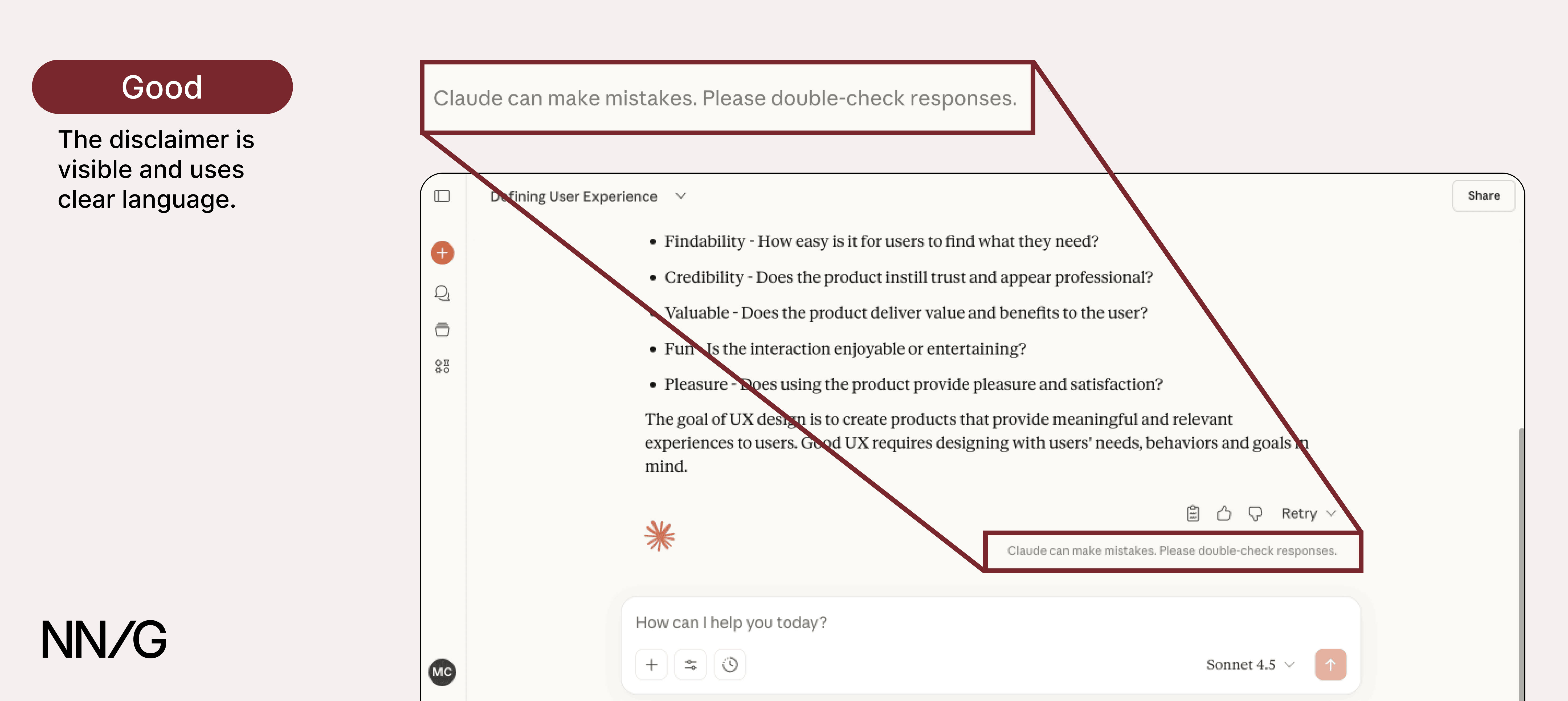

Si bien las exenciones de responsabilidad pueden parecer efectivas en teoría, sólo son útiles si los usuarios las leen. Las investigaciones muestran consistentemente que las personas a menudo simplemente Ver texto En lugar de leer cada palabra y saltarse la letra pequeña por completo. Si las exenciones de responsabilidad están ocultas en la parte inferior del resultado, ocultas detrás de un ícono de ayuda o escritas en un lenguaje oscuro, los usuarios tienden a ignorarlas por completo.

Cuando las exenciones de responsabilidad están bien diseñadas, es más probable que se noten y pueden ayudar con éxito a los usuarios a calibrar su confianza y utilizar las herramientas de inteligencia artificial de manera crítica. He aquí cómo:

- Utilice un lenguaje claro para escribir su descargo de responsabilidad. Restricciones de descripción de uso lenguaje sencillo y directo Déjalo claro a los usuarios. Evite la jerga técnica O terminología de inteligencia artificial.

- Combine una exención de responsabilidad con una acción. Además de indicar las limitaciones, informe a los usuarios exactamente qué deben hacer (p. ej. Verifique dos veces la salida de IA).

- Coloque el descargo de responsabilidad en un lugar destacado de la interfaz principal.es mejor estar más cerca del cuadro de entrada ya que los usuarios tienden a centrar su atención. No los coloque en el pie de página ni detrás de un ícono de ayuda donde puedan pasarse por alto fácilmente.

- Incluir un descargo de responsabilidad en la incorporación Establezca expectativas con anticipación.

Evite el lenguaje antropomórfico

Inteligencia artificial antropomorfao darle un nombre, personalidad o historia de fondo puede hacer que la herramienta parezca amigable y accesible, pero también puede Confianza inflada y establecer expectativas poco realistas.

Cuando una explicación parece escrita por un humano (p. ej., Consideré tu pregunta y busqué en línea.), los usuarios pueden sobreestimar la inteligencia y las capacidades del modelo. En su lugar, utilice un lenguaje objetivo y neutral (p. ej. Esta respuesta se basa en la siguiente fuente: (enlace). )

Sea honesto y transparente acerca de las limitaciones.

Los practicantes de UX siempre son responsables de dar forma modelo mental y ayudar a las personas a comprender las nuevas tecnologías. Se confiaron en las primeras interfaces digitales esqueuomorfismoutilizando metáforas físicas familiares como carpetas y contenedores para hacer que las interacciones digitales sean fáciles de entender. Diseñar IA explicable es la última versión de nuestro desafío de hacer que los productos sean confiables y comprensibles para que los usuarios puedan aprovechar al máximo la tecnología. Para la IA, esto significa comunicar honestamente las limitaciones de la IA y mitigar el riesgo de una confianza excesiva para que los usuarios puedan interactuar de forma segura con estas herramientas de IA.

referirse a

Miles Turpin, Julian Michael, Ethan Pérez y Samuel R. Bowman. 2023. Los modelos de lenguaje no siempre dicen lo que piensan: una explicación de la infidelidad en la cadena de pensamiento sugiere. existir Actas de la 37ª Conferencia Internacional sobre Sistemas de Procesamiento de Información Neural (NIPS ’23). Curran Associates Inc., Red Hook, Nueva York, EE. UU., Artículo 3275, 74952–74965.