La inteligencia artificial exige precisión: lecciones del Instituto Baymard

Resumen:

El resultado de la mayoría de las herramientas de UX impulsadas por IA carece de confiabilidad y responsabilidad. Exija transparencia y precisión comprobada o no compre.

Las herramientas de UX impulsadas por IA prometen eficiencia, pero a menudo carecen de transparencia sobre su precisión o limitaciones. En este episodio del podcast UX de NN/g, los cofundadores de Baymard, Christian y Jamie Holst, analizan por qué la IA en UX y otros campos profesionales necesita un estándar más alto, y explican el enfoque de Baymard para crear UX-Ray, una herramienta de evaluación de comercio electrónico impulsada por IA.

Conozca a Christian y Jamie Holst, cofundadores del Instituto Baymard

Christian y Jamie Holst son hermanos y cofundadores del Baymard Institute, una organización independiente de experiencia de usuario profesional de comercio electrónico que ha desarrollado cientos de pautas prácticas para el diseño de comercio electrónico. Al igual que NN/G, Baymard pone un gran énfasis en la orientación de diseño respaldada por la investigación, pero su trabajo se centra particularmente en el comercio electrónico.

Christian es el director de investigación de Baymard, donde supervisa toda la investigación sobre la experiencia del usuario. Jamie es director de tecnología, responsable del desarrollo tecnológico de Baymard y es conocido por sus escritos sobre la intersección de la tecnología y la experiencia del usuario.

Muchas herramientas de UX impulsadas por IA prometen evaluaciones heurísticas, auditorías de UX o información instantánea. Sin embargo, la mayoría no revela la exactitud de estos resultados ni cuándo no deberían utilizarse. Esta tendencia es especialmente grave en 2023, pero incluso a medida que avanza la tecnología de IA, muchas herramientas utilizadas para el trabajo de UX todavía carecen de confiabilidad.

Christian y Jamie señalan que la mayoría de las herramientas de IA para UX ni siquiera lo mencionan (y mucho menos lo miden e informan al respecto). Cómo se compara su precisión con la producción generada por humanos.

“La gran mayoría de las herramientas ni siquiera publican índices de precisión. Así que ni siquiera podemos discutir si es lo suficientemente alto. “

—Christian Holst

Como ejemplo, consideremos una herramienta de inteligencia artificial que promete “escanear” su sitio web, identificar posibles problemas en la experiencia del usuario y proponer soluciones. A primera vista, esto suena tentador, especialmente para equipos con experiencia limitada en UX o que necesitan evaluar muchas páginas rápidamente. Qué La mayoría de herramientas como esta hipotética no proporcionan -y Lo que muchas autoridades ni siquiera piden es transparencia sobre sus limitaciones.

Las herramientas impulsadas por IA diseñadas para escanear páginas en busca de problemas de UX identificables a menudo solo pueden detectar ciertos tipos de problemas (como contraste visual deficiente, copia inconsistente o espacio en blanco insuficiente) en lugar de resolver todos los tipos de problemas de UX. Los sistemas impulsados por GenAI pueden tener dificultades para identificar problemas más profundos y sutiles, como un desajuste fundamental entre la arquitectura de información de un sitio web y las expectativas de su público objetivo. pero ¿Con qué frecuencia ves que estas herramientas de inteligencia artificial reconocen de manera transparente estas limitaciones?

Cuando se trata de diseño de producto, “bastante bueno” no es suficiente

En muchos casos, las limitaciones de las herramientas AI UX son realmente cuantificables. Cuando se lance el modelo GPT-4 de ChatGPT en 2023, con la capacidad de procesar imágenes, desbloqueará la capacidad de “auditar” interfaces digitales utilizando herramientas de inteligencia artificial para el consumidor. El equipo de Baymard probó la nueva característica realizando auditorías de la experiencia del usuario de 12 páginas web utilizando GPT-4 y comparando el resultado de la herramienta con los problemas identificados por expertos humanos. El rendimiento del GPT-4 es muy pobre: sólo un 20% de precisión. El 80% de las recomendaciones que hace son falsos positivos. Encontró sólo el 14% de los problemas de experiencia del usuario en las pantallas de entrada.

Por supuesto, desde entonces se han realizado mejoras sustanciales en la arquitectura del modelo, los datos de entrenamiento y la interpretabilidad. Algunas herramientas de inteligencia artificial más nuevas ahora brindan justificaciones más detalladas de sus resultados, lo que permite a los usuarios comprender por qué se hicieron recomendaciones específicas. Además, los avances en el ajuste y la ingeniería justo a tiempo permiten que los modelos se adapten a dominios específicos, lo que potencialmente mejora la relevancia y precisión de las tareas especializadas de experiencia del usuario.

En marzo de 2025, dos investigadores de Microsoft realizaron una evaluación similar de cuatro herramientas de inteligencia artificial. Descubrieron que la precisión de las herramientas oscilaba entre el 50 y el 70 por ciento. A modo de argumento, supongamos que las herramientas de UX impulsadas por IA ahora pueden tener una tasa de precisión de alrededor del 70%.

Incluso esta precisión mucho mayor puede resultar peligrosa. Cristian explicó:

“A primera vista, esto parece una tasa aceptable. Puedo imaginar fácilmente a un CEO o CMO mirando esto y diciendo: ‘Bueno, esta herramienta barata es correcta alrededor del 70 por ciento de las veces, ¡deberíamos usarla!’

El problema es que es En realidad, una propuesta de valor terrible.. Creo que las personas que llevan mucho tiempo en el campo de la experiencia del usuario lo reconocerán y comprenderán. “

—Christian Holst

Por ejemplo, supongamos que una herramienta de evaluación heurística le proporciona 10 sugerencias para mejorar su experiencia. Siete de ellos fueron buenos consejos… pero tres no lo fueron. Pueden empeorar activamente su experiencia y reducir las tasas de conversión. Pero no se puede saber qué consejo es bueno.

|

Escuche más conversaciones con líderes de la industria. Suscríbete al podcast UX de NN/G Spotify, YouTubeo tu aplicación de podcast favorita. |

Los pequeños detalles son muy importantes

Los profesionales experimentados en UX saben que pequeños ajustes de diseño pueden tener un gran impacto en los usuarios y la empresa. Christian y Jamie describen cómo un cliente reciente, un minorista de ropa Fortune 500, generó millones de dólares en ingresos al aumentar las tasas de conversión en un 1 % al reemplazar los indicadores de puntos con miniaturas en un carrusel de imágenes de productos.

Es fácil imaginar un escenario inverso, donde una pequeña sugerencia podría tener un impacto negativo enorme. ¿Qué pasaría si el cliente de este ejemplo pidiera una herramienta de inteligencia artificial para evaluar la página de su producto? La herramienta podría decir “Reemplazar miniaturas con puntos de carrusel para reducir el desorden visual”. Si un equipo sigue este consejo sin dudarlo, es posible que, sin darse cuenta, reduzca las tasas de conversión sin siquiera darse cuenta de por qué sucede esto.

La precisión es lo primero: estudio de caso de rayos UX

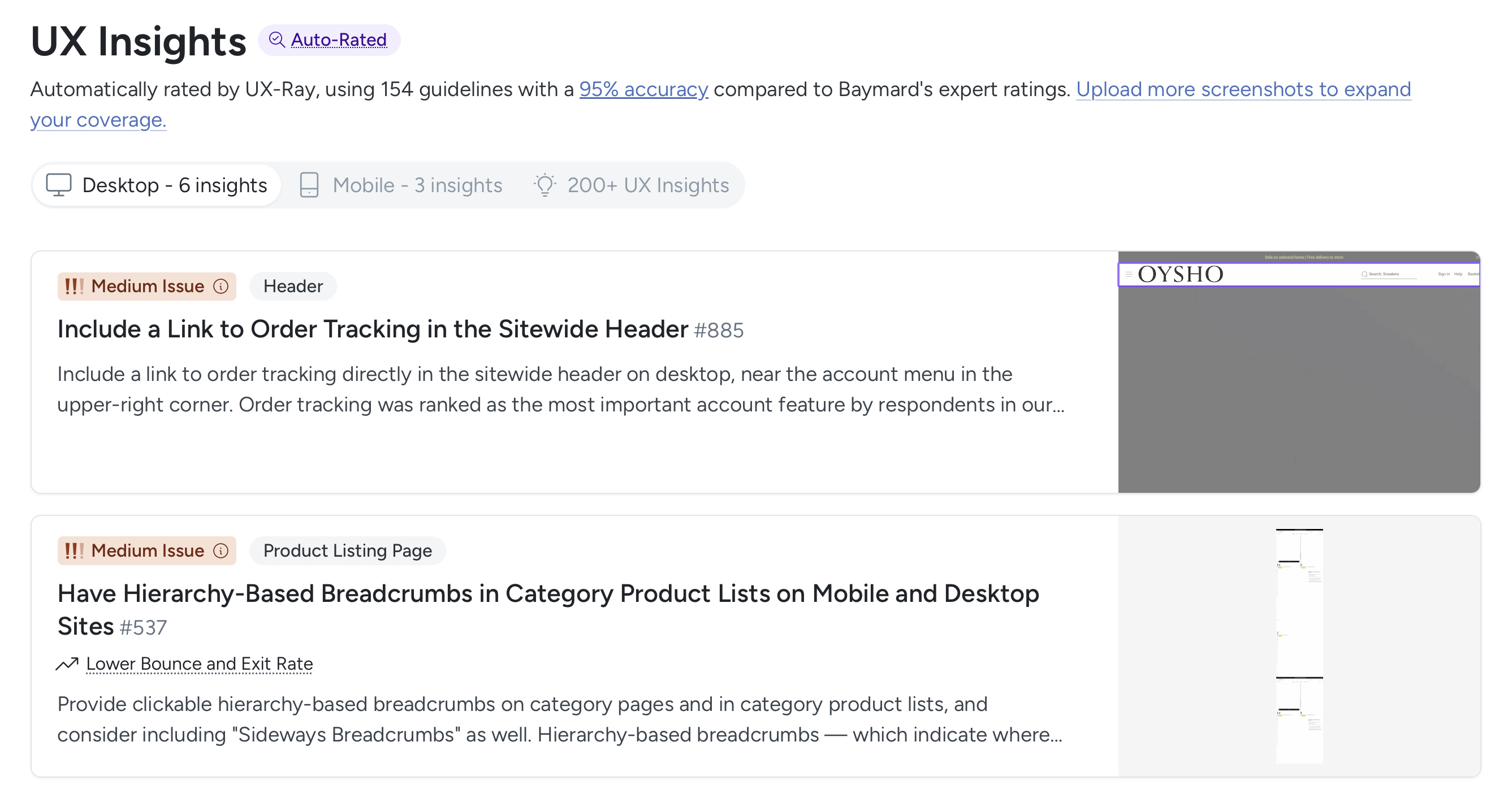

Frustrados por la proliferación de herramientas de inteligencia artificial poco confiables en el mercado, Christian y Jamie crearon su propia herramienta, a la que llamaron UX-Ray.

Esta herramienta compara específicamente los sitios web de comercio electrónico con un subconjunto de los cientos de pautas de Baymard. (Al momento de escribir este artículo, UX-Ray examina solo 154 guías (aproximadamente entre el 20 y el 25 % del conjunto completo de más de 700 guías de comercio electrónico).

¿Por qué la herramienta de Baymard sólo comprueba aproximadamente una cuarta parte de sus directrices? porque Priorizar la precisión — Christian y Jamie optaron por incluir solo aquellas pautas para las cuales el sistema de IA puede lograr al menos un 95% de precisión. La precisión se determina mediante pruebas de estrés de UX-Ray en varios entornos diferentes y comparando sus resultados con evaluaciones humanas del mismo diseño.

Christian admite que comprende por qué muchas herramientas de inteligencia artificial utilizadas para la experiencia del usuario no evalúan la precisión, ya que dicha evaluación requiere mucho tiempo y recursos, lo que hace que sea fácil evitarla en favor de afirmaciones de marketing más atractivas (aunque engañosas). Pero Baymard no cree que este enfoque sea ético o sostenible en términos de crear clientes felices a largo plazo.

Utilice GenAI solo cuando sea confiable

Jamie Holst explica que el gran avance en la creación de UX-Ray se produjo cuando dividieron el proceso en dos etapas distintas: clasificación y análisis. Señaló que los modelos de aprendizaje automático son buenos para tareas de clasificación, como identificar qué patrones de diseño están presentes en una interfaz. Sin embargo, Jamie enfatiza que evaluar la bondad de un patrón de diseño particular (esencialmente la calidad de la experiencia del usuario) requiere una comprensión profunda del contexto y un conocimiento altamente especializado.

“El segundo paso es determinar: ‘¿Es este (el patrón de diseño) el problema aquí? ¿Es bueno, malo o algo intermedio?’ Descubrimos que cuando les pides a los LL.M. que hagan eso, las cosas se descarrilan. Ahí es donde la precisión cae drásticamente”.

—Jamie Holst

Jamie y su equipo descubrieron que cuando se pedía a grandes modelos de lenguaje que clasificaran y analizaran patrones de diseño, las tasas de error se exacerbaban y la precisión disminuía significativamente. Por lo tanto, UX-Ray se basa en La IA probabilística solo se utiliza para reconocer patronesmientras que todos los análisis de evaluación se manejan de manera determinista a través de una lógica predefinida basada en la investigación de Baymard. Pusieron barreras alrededor de la IA.

Este enfoque utiliza inteligencia artificial donde es más confiable (coincidencia de patrones) y, al mismo tiempo, se basa en reglas definidas por humanos para la evaluación de la experiencia del usuario real, lo que en última instancia conduce a una mayor precisión. Jamie concluyó que, si bien los avances futuros en inteligencia artificial pueden hacer que el análisis sea más factible, los modelos actuales aún no son capaces de afrontar este paso de forma fiable.

Si bien genAI aporta un gran potencial a la investigación y el diseño de la experiencia del usuario, no es una solución única para todos. Si tiene la tarea de evaluar, probar e implementar estas herramientas de inteligencia artificial en el trabajo de su equipo, Exigir a los proveedores altos estándares. No les basta con decir simplemente “está impulsado por la IA”. Pregúntele a su representante de ventas:

- ¿Cómo se evalúa la precisión y la confiabilidad? ¿El resultado de su herramienta?

- ¿Cuáles son las limitaciones de esta herramienta? ¿Dónde podría estar dañado o proporcionar información inexacta?

- ¿Qué barandillas hay? para evitar errores? ¿Qué papel juega exactamente genAI en la creación del resultado final?

Antes de comprar estas herramientas, sea responsable de sus estándares de calidad. Si no lo hace, su equipo eventualmente lo hará responsable.